Netpeak Spider и Netpeak Checker — новое поколение любимых SEO-инструментов. Что такое Netpeak Spider

Каждому вебмастеру приходится постоянно решать повседневные проблемы, касающиеся SEO-оптимизации и продвижения сайта. И одним из лучших инструментов, позволяющих это сделать, является программа Netpeak Spider. Благодаря ей можно сканировать и анализировать веб-ресурсы, сделав этот процесс простым и удобным.

Установка Нетпик Спайдер

Скачать программу можно на официальном сайте разработчика по ссылке https://netpeaksoftware.com/spider . Но перед этим необходимо зарегистрироваться, а также купить платную версию или запустить триал на 14 дней. После регистрации у вас появится возможность скачать установочный файл Нетпик Спайдер. Сам процесс инсталляции интуитивно понятен, и с ним справится даже начинающий вебмастер.

Установленный пакет содержит 2 программы – сам Netpeak Spider, и Netpeak Checker – сервис для массового Сео-анализа. Каждую из программ придется установить отдельно.

Возможности этой программы для seo анализа

С помощью Netpeak Spider Вы сможете:

отследить свыше 50 главных характеристик, связанных с оптимизацией ресурса;

получить перечень ссылок, как внешних, так и внутренних;

обнаружить, есть на ли вашем сайте нерабочие линки и редиректы;

узнать, содержит ли ресурс дубли страничек и мета-тегов title, description, h1;

проверить, соответствуют ли файлы robots.txt и использованные теги canonical рекомендациям популярных поисковиков;

проверить как весь ресурс, так и его часть;

Инструкция по использованию Нетпик Спайдер

Первое, что стоит сделать, это сменить язык программы для seo анализа с английского на русский. После этого работать с ней становится еще легче.

Чтобы запустить сканер, нужно ввести URL сайта в специальное поле ввода, и нажать кнопку «Старт». Программа выдаст перечень ошибок и проблем, которые при желании можно отфильтровать. Нажмите на любую из категорий для просмотра всех ошибок, входящих в нее.

Во вкладке «Инструменты» можно проанализировать исходный код ресурса, рассчитать внутренний Page Rank страниц, а также сгенерировать карту сайта – Sitemap.

Для получения списка проблем другого ресурса придется создать новый проект. Сделать это можно во вкладке «Проект». Здесь же можно сохранить результаты сканирования или открыть полученные ранее.

Всем привет! 🙂

Несмотря на то, что зоной моих профессиональных интересов является Web-программирование, время от времени я интересуюсь такой темой, как SEO. Хотя бы для того, чтобы привлекать трафик на данный сайт, да и по работе иногда задачи, связанные с , появляются.

Итак, о чём сегодня будет идти речь?

Скажу сразу, что штука эта интересная, может многое, но и без претензий с пожеланиями к разработчикам не обошлось. В общем, к чему эти интриги… 🙂 Сами обо всём узнаете дальше.

Поехали! 🙂

Что такое Netpeak Spider?

О том, для чего нужна данная SEO программа, можно узнать, расшифровав её название.

Если вы интересуетесь SEO, то, наверняка, вам знакома компания Netpeak, т.к. статьи её блога находятся в ТОПе поисковой выдачи по многим запросам (даже по запросу SEO , обходя Википедию), а также её продукты, о которых часто упоминается на сторонних ресурсах, занимающих ТОП по другим запросам.

Так что, как ни крутите, если в SEO вы не первый день, то о Netpeak вы просто обязаны были слышать 🙂 Но, если быть точными, разработчиками Netpeak Spider является Netpeak Software, которая является частью Netpeak Group.

Ну, а Spider — это, в переводе с английского, «паук». Паук плетёт паутину или сеть, другими словами. А поскольку Интернет — это тоже сеть, то спайдерами часто называют программы, которые занимаются поиском информации и дальнейшей обработкой собранных в Интернете данных.

Такая вот игра слов 🙂

Какую же информацию собирает в сети Нетпик Спайдер?

Поскольку Netpeak, как уже говорилось, является компанией, специализирующейся на SEO разработках, то, как ни странно, данный продукт позволяет провести комплексный SEO аудит сайта, взглянув на него глазами поисковых роботов.

Таким образом, Netpeak Spider может быть полезен при проведении следующих мероприятий:

- Технический SEO аудит сайта: поиск битых ссылок, ошибок в коде, плохо настроенных редиректов, дублей контента и метаданных, title, description и др.

- Анализ ссылочной массы веб-сайта в общем (внешней и внутренней), а также для каждой его отдельной страницы.

- Проверка сайта на SEO ошибки, отрицательно влияющих на его позиции в поисковой выдаче и usability: битые картинки, ссылки на несуществующие страницы (возвращающие код 404 HTTP запроса к таким страницам) и т.д.

- Установка причины неработоспособности сайта (бесконечный редирект) или отдельных его страниц (404, 500, 503 код ответа сервера).

- Анализ SEO оптимизации сайта, проведённой сторонними исполнителями, для контроля её качества.

Собственно говоря, необходимость проведения очередного SEO аудита и свела меня с Netpeak Spider, который, как уверяют его разработчики, учитывает больше параметров при анализе (54) и позволяет выявить большее количество ошибок (62) по сравнению с конкурентами, обращая внимание даже на незаметные с первого взгляда мелочи.

SEO аудит с помощью Нетпик Спайдер

Протестировать возможности данной программы SEO анализа я решил, естественно, на примере текущего сайта — http://сайт.

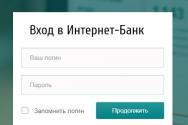

Чтобы это сделать, для начала нужно Netpeak Spider скачать. Для этого, в свою очередь, нужно завести Netpeak аккаунт путём регистрации на официальном сайте и скачать Launcher, через который уже и можно будет скачать Netpeak Spider и прочие продукты данной компании.

Несмотря на то, что данный продукт платный, его можно бесплатно использовать в течении 14 дней без каких-либо ограничений в возможностях, т.е. с полным функционалом.

А это, кстати, весомое преимущество над другими SEO инструментами, например , функционал которого на пробном периоде весьма ограничен: анализировать можно только один сайт, количество запросов ограничено и т.д.

После установки программы на свой ПК (использовать Netpeak Spider можно как на Windows машинах, так и на Mac OS) единственное, что нужно сделать для запуска SEO анализа сайта, это ввести URL сайта в адресную строку:

При вводе доменного имени сайта в строку поиска, анализ ресурса происходит с учётом HTTPs протокола по умолчанию. Поэтому, если у вас ресурс работает по HTTP (как у меня), то указывайте протокол явно.

Перед запуском SEO анализа сайта программа также предлагает выбрать параметры, на основании которых он будет производиться:

Как видите, можно даже формировать и загружать шаблоны параметров. Думаю, компании, оказывающие услуги SEO продвижения своим клиентам, оценят данный функционал по достоинству 🙂

Для запуска самого сканирования ресурса нужно нажать на кнопку Старт , расположенную рядом с полем для ввода URL сайта.

После SEO анализа ресурса на предмет ошибок (прошёл он, кстати, достаточно быстро — за 4 с копейками минуты, при том что на сайте больше 150 страниц) я получил следующую картину на вкладке Отчёты , на которую устанавливается фокус после запуска сканирования:

Одной из критичных ошибок было отсутствие значения description у некоторых страниц. Меня данная SEO ошибка сайта, честно говоря, немного обескуражила, потому что я старательно заполняю данное поле у каждой публикуемой статьи.

Однако, оказалось, что ошибка относилась к страницам категорий, для которых я действительно забыл указать значение для тэга meta description.

После внесения правок на сайте и запуска повторной проверки в Netpeak Spider, данная ошибка исчезла, что вы и могли заметить на скриншоте выше. Т.е. программа реагирует на внесённые изменения мгновенно.

Также данная SEO программа помогла мне обратить внимание на висячие 301 редиректы, которые я забыл убрать из.htaccess, когда переименовывал url существующих статей и прописывал там перенаправление со старых адресов на новые.

Однако, помимо реальных, пропущенных мною редиректов, были и какие-то «левые» следующего формата:

Что самое интересное, эти фейковые «битые» редиректы были разные при различных сканированиях 🙂

Данное замечание было справедливо также и для других пунктов отчёта, а также целых блоков ошибок, которые при повторных запусках SEO анализа сайта неизвестно куда пропадали или появлялись. Это при том, что на самом ресурсе никаких изменений не производилось.

Например, Netpeak Spider для некоторых страниц показал 503 код ошибки, хотя по факту они доступны и индексируются:

Для уверенности я решил проверить сомнительный URL через эмулятор поисковых роботов , но результат оказался тот же. Да и в индексе поисковых систем данные страницы доступны:

Разгадка данного поведения Netpeak Spider оказалась весьма банальной и заключалась в обширных настройках SEO программы и, в частности, в количестве потоков сканирования, которых по умолчанию было 10:

Установив 1 поток, я получил реальную картину дел на своём сайте, которая оказалась более оптимистичной, чем на скринах выше.

К чему я всё это рассказал? К тому, что настроек у Netpeak Spider очень много, и они позволяют сконфигурировать программу на любой вкус и цвет, удовлетворяя потребности самых искушенных пользователей.

Благо, что у каждого пункта есть всплывающие подсказки, позволяющие понять суть каждой настройки и сконфигурировать Netpeak Spider должным образом даже новичку.

Если же даже они вам не помогут, то вы всегда можете обратиться в техническую поддержку Нетпик Спайдер через официальный сайт, ссылку на который я приводил ранее.

Ещё одной проблемой моего сайта, на которую я обратил внимание благодаря Netpeak Spider, стало отсутствие заголовка h1 на страницах категорий статей, который был просто не учтён используемым мною шаблоном.

Естественно, я это исправил, тем более, что программа отнесла данное упущение к ошибкам в SEO средней критичности.

Очередным резонным замечанием в адрес моего сайта была работа по протоколу HTTP, в то время как уже несколько лет Google рекомендует (чуть ли не требует) от сайтов работу по защищённому HTTPs протоколу.

С этим я пока что ничего не могу поделать, т.к. — занятие ответственное и весьма трудозатратное, к которому нужно подходить взвесив все плюсы и минусы, о чём более детально вы можете прочитать в статье по ссылке.

Но это бездействие временное и в скором будущем, я думаю, что переключусь на HTTPs.

Остальные же ошибки, найденные Netpeak Spider на моём сайте, были вызваны особенностями CMS WordPress, на базе которой он и разработан. Они касались множества лишних ссылок формата http://url_статьи/feed и http://url_статьи?replytocom=123, которые я закрыл от индексации, но физически они на сайте присутствовали.

Так что если у вас будут обнаружены те же самые проблемы, то не расстраивайтесь — нас таких много 🙂 А если серьёзно, то большого вреда данные нюансы WordPress вам всё равно не принесут. По крайней мере, такой информации в сети я не встречал.

Теперь пару слов об ошибках, которые можно обнаружить на своём сайте с помощью Netpeak Spider, но с которыми я не столкнулся, поэтому и не упомянул о них:

- дубли страниц (url), контента и мета-данных;

- страницы сайта с большим количеством редиректов (включая бесконечный);

- битые изображения;

- страницы без внутренних ссылок (нарушают естественное распределение ссылочного веса);

- несколько одноимённых meta тэгов (title, description, h1) в рамках одной страницы;

- страницы с малым контентом, длинными url, большим временем загрузки, слишком тяжёлыми изображениями;

- url сайта, заблокированные в robots.txt (да, Netpeak Spider может его считывать и анализировать), а также автоматически проводится проверка наличия данного файла на сайте;

- страницы с одинаковым title и description (оказывается, это тоже грех в мире SEO), а также имеющие слишком длинные/короткие их значения.

Помимо перечисленных критериев SEO аудита сайта, проводимого программой Нетпик Спайдер, в данном продукте существует ещё много дополнительных плюшек в виде различного рода инструментов, о которых я тоже хотел бы сказать пару слов.

Встроенные SEO инструменты Netpeak Spider

В самой программе для SEO анализа сайта их можно найти в пункте главного меню Инструменты . Эх, никакой интриги 🙂

Первым из них является анализатор исходного кода страницы и ответа сервера на HTTP запрос (заголовки, код ответа и, собственно, тело), который выглядит вот так:

По сути, он является неким симбиозом и его же инспектора исходного кода, который открывается с помощью комбинации клавиш Ctrl+U.

Если данный инструмент не представляет собой ничего революционного, то аналогов следующего я на данный момент ещё не встречал.

Речь идёт о PageRank Checker — инструменте, позволяющем проверить PageRank, т.е. относительный вес страницы сайта, который выглядит следующим образом:

Формула расчёта представлена вверху экрана.

Полезность данной фишки заключается в том, что он позволяет понимать, на каких страницах концентрируется ссылочный вес.

Это, в свою очередь позволяет корректировать стратегии ссылочного продвижения (ссылками лучше продвигать страницы с низким ссылочным весом, на тяжеловесные пользователь и так попадёт по внутренним ссылкам).

А также калькулятор PageRank позволяет определять страницы, которые «прожигают» ссылочный вес, т.е. на которые ведёт много внутренних ссылок, но целевая страница либо недоступна, либо не очень важна для поискового продвижения.

Следующим интересным SEO инструментом из комплекта Netpeak Spider является валидатор XML Sitemap карты сайта, который выглядит следующим образом:

С его помощью можно проанализировать XML карту сайта на предмет ошибок и соответствия её требованиям поисковых систем (Google, Bing, Яндекс). Также здесь имеется возможность сообщить поисковикам о наличии на сайте карты.

Ну, а для тех, у кого карты ещё нет, Netpeak Spider как раз имеет подходящий инструмент, позволяющий сделать карту сайта XML, который выглядит так:

Мелочь, но всё же приятно, когда генератор XML карты сайта под рукой, и не нужно тратить силы на его поиски в Интернете 🙂

Кроме всего перечисленного, Netpeak Spider позволяет экспортировать собранные в процессе SEO аудита данные в Excel документы для предоставления их клиентам, начальству для отчётности или просто для себя любимого, чтобы вернуться к анализу собранных программой данных позже.

Работа с Netpeak Spider: выводы

Несмотря на некоторые недостатки и спорные моменты при работе с программой, работой с Netpeak Spider я остался доволен.

SEO аудит с её помощью был проведён в полной мере, а также данная программа обратила моё внимание на некоторые моменты, о которых мне не сообщали другие SEO сервисы.

При этом Netpeak Spider достаточно быстро работает и имеет понятный и удобный интерфейс, делающий её использование максимально удобным.

Если оценивать данный продукт по 10-бальной шкале, то Netpeak Spider, как по мне, заслуживает 8-ку.

Один бал я срезал за технические моменты, а второй за то, что продукт коммерческий. Хотя для студий, занимающихся SEO продвижением профессионально, да и обычным веб-мастерам, которые хотят сэкономить и произвести SEO оптимизацию сайта самостоятельно, 120$ в год или 14$ в месяц вряд ли нанесут серьёзный урон кошельку.

Да, я не опечатался по поводу экономии на SEO продвижении за счёт платной программы. Дело в том, что если вы обратитесь к профессионалам (которые с большой вероятностью будут пользоваться тем же Netpeak Spider или аналогами), то стоимость их услуг будет в разы больше, чем приобретение лицензии.

Также стоит отметить, что рассмотренные в данной статье возможности характерны для Netpeak Spider 3.0, релиз которой состоялся сравнительно недавно. Так что если вы ещё пользуетесь предыдущими версиями, данная новость — отличный повод скачать свежачок и оценить новые функции.

Если же вы не работали с данным продуктом вовсе, то, несмотря на мою оценку и данный обзор, рекомендую сформировать своё собственное мнение.

Напомню, что скачать Netpeak Spider вы можете . При скачивании по данной ссылке вы дополнительно получите скидку в 10%, как участник партнёрской программы. Поэтому не нужно жадничать и выдумывать способы обхода реферальных ссылок 🙂

На этом у меня сегодня всё. Пишите ваши отзывы в комментариях (я их читаю, честно 🙂), там же делитесь мнениями и опытом использования Netpeak Spider для решения своих задач и не забывайте делиться публикацией с друзьями.

Провели SEO анализ своего сайта — помогите сделать его и своим товарищам! Уверен, что лишним он точно не будет, как и в моём случае, когда я думал, что мой сайт по SEO идеален 🙂

Удачи всем и до новых встреч! 🙂

P.S. : если вам нужен сайт либо необходимо внести правки на существующий, но для этого нет времени и желания, могу предложить свои услуги.

Более 5 лет опыта профессиональной разработки сайтов. Работа с

Веб-сайты, содержащие десятки, а то и сотни тысяч страниц, руками не проверишь, для адекватного SEO-аудита используют программы-краулеры, благодаря которым ресурсы сканируются в автоматическом режиме. Обычно для этих целей используются две общепризнанные во всём мире программы:

- (промокод в конце статьи)

В результате сканирования вебмастера могут увидеть полную картину технического состояния сайта с точки зрения поискового продвижения. Опытный SEO-специалист интерпретирует результаты и найдет корреляции с получаемым трафиком и позициями сайта в поисковой выдаче.

Краткий обзор Netpeak Spider

Интерфейс выглядит вот так:

Можно переключиться на Дашборд, который покажет общую картину по техническому состоянию сайта:

В этом видео CEO Netpeak Software Alex Wise рассказывает об обновлённом инструменте Netpeak Spider 3.0:

Это десктопная программа для анализа технической составляющей веб-сайтов, которая сканирует ресурсы на предмет ошибок с точки зрения поискового продвижения (SEO), её основные возможности:

- Проверка 50+ основных SEO-параметров;

- Определение 60+ ключевых ошибок внутренней оптимизации;

- Анализ входящих и исходящих внутренних ссылок;

- Обнаружение битых ссылок и редиректов;

- Дублирование контента: страниц, Title, Meta Description, заголовков h1 и т.д.;

- Учёт инструкции по индексации (robots.txt, Meta Robots, X-Robots-Tag, Canonical);

- Рассчет внутреннего PageRank страниц для улучшения внутренней перелинковки сайта;

- Настройка собственных правил сканирования для обхода определённой части сайта;

- Сохранение и экспорт полученных данных для последующей работы.

Краткий обзор Screaming Frog SEO Spider

Интерфейс программы:

В видео вы найдете практические рекомендации по работе со Скримин Фрог, а также узнаете основные моменты, на которые стоит обратить внимание при проведении постраничной оптимизации: советы по написанию title, description, заголовков, формированию URL-адресов страниц и многое другое.

Screaming Frog SEO Spider - аналог Netpeak Spider’a со своими плюсами и минусами. Что умеет программа:

- Поиск битых страниц и страниц с редиректами, отображение анкоров;

- Поиск страниц с короткими, длинными, дублирующимися тегами title / description;

- Поиск страниц, на которых тег h1 дублируется или отсутствует;

- Поиск изображений с отсутствующими и длинными атрибутами alt и title тега img;

- Отображение информации по атрибутам rel=»canonical», rel=»next», rel=»prev» тега link;

- Выгрузка содержимого по регулярному выражению (например, парсинг всех тегов).

- Отображение структуры сайта и уровня вложенности страниц;

- Проверка времени загрузки страниц;

Мне нравятся обе программы, но N etpeak S pider выигрывает по удобству и скорости, а это важно, когда имеешь дело с большим e-commerce. Ниже таблица от команды Netpeak Software с подробным описанием основных фич программы Netpeak Spider по сравнению с Screaming Frog SEO Spider.

| В чём Netpeak Spider превосходит Screaming Frog SEO Spider | |

|---|---|

| Название фичи | Пояснение |

| Критичные фичи | |

| Оптимальное потребление оперативной памяти | Мы провели исследование, просканировали на идентичных настройках 1 млн страниц сайта opera.com. Получили такой результат по потреблению оперативной памяти и времени сканирования. 1. SFSS пробил 1KK URL в режиме Memory за 18 часов 38 минут и потратил 21 359 Mb оперативки. Сохранение этого количества урлов после сканирования заняло 11 часов. Вывод: Netpeak Spider выигрывает по потреблению оперативной памяти по сравнению с SFSS в обоих режимах. |

| Топовая скорость сканирования сайтов | Недавно мы провели сравнение Netpeak Spider 3.0 c известными продуктами (Screaming Frog SEO Spider, WebSite Auditor, SiteBulb) по трём техническим параметрам: потреблению оперативной памяти, потреблению памяти на жёстком диске, скорости сканирования. Детально об этом можете почитать по ссылке: https://goo.gl/6EUU25 Если кратко, то при анализе небольшого сайта (10К страниц) по потреблению оперативной памяти лидер Netpeak Spider (ближайший конкурент потребляет в 2 раза больше), а по скорости сканирования мы идём наравне со Screaming Frog SEO Spider (в режиме Memory). А при анализе большого сайта (100К страниц) у нас самое быстрое сканирование, которое потребляет меньше всего оперативной памяти. |

| Фокус на устранении SEO-ошибок | 1. Netpeak Spider определяет в 2 раза больше ошибок, чем Screaming Frog SEO Spider. Более того, на боковой панели «Отчёты» есть вкладка «Ошибки», в которой все проблемы сайта разбиты по степени критичности. Программа покажет вам только ту информацию, которая есть на сайте и на которую нужно обратить внимание. Также можно увидеть ненайденные и отключёные ошибки → они удобно отфильтровываются в самом низу вкладки «Ошибки». 2. Можно фильтровать результаты по определённой ошибке по клике на неё в боковой панели → в таблице отобразятся колонки, уникально подобранные для конкретной ошибки (а если необходимо, можно включить все колонки). 3. URL c ошибками подсвечиваются в таблице цветами в зависимости от степени критичности, причём как в самой программе, так и при экспорте в Excel. 4. При клике на некоторые ошибки есть отдельная кнопка «Отчёт по ошибке» → открывается отчёт с дополнительной информацией, заточенной под работу именно с этой ошибкой («Битые ссылки», «Ссылки с неправильным форматом URL», «Редирект, заблокированный в robots.txt», «Canonical, заблокированный в robots.txt», «Изображения без атрибута ALT», «Внутренние nofollow ссылки», «Внешние nofollow ссылки»). 5. Очень удобно использовать в связке с функцией сегментации. |

| Управление параметрами сканирования | 1. В Netpeak Spider можно включать и отключать пробивку определённых параметров (title, description, canonical, ссылки etc.). Это позволяет ускорить сканирование, уменьшить потребление оперативной памяти и ресурсов процессора. Если сайт очень большой, то появляется возможность его просканировать, выбрав только самые нужные параметры. 2. После пробивки из вкладки «Параметры» можно быстро переходить к определённому параметру в текущей таблице → достаточно просто кликнуть на нужный параметр, и таблица прокрутится до необходимой колонки. 3. На этой же вкладке можно использовать шаблоны параметров сканирования: как преднастроенные, так и свои личные именно для ваших задач. 4. Тамже можно использовать быстрый поиск по параметрам, ведь их достаточно много 5. Если вы уже просканировали полсайта с одними параметрами и поняли, что какие-то параметры нужно выключить или наоборот включить, можно остановить сканирование, внести нужные изменения в выборку параметров и продолжить краулинг дальше: новые настройки сработают сразу же (разумеется, у пробитых до этого URL не будут видны параметры, которые только что были включены). |

| Функция сегментации данных | 1. После завершения сканирования можно изменить представление данных в программе, ограничивая их определённым сегментом (аналогично сегментации в Google Analyics). Можно настроить сегмент самостоятельно или применить как сегмент любой фильтр, доступный в программе. 2. Сегментация → это очень мощная аналитическая функция, у которой есть множество применений в программе. Например, выберите в отчёте «Структура сайта» какую-то категорию, примените как сегмент и теперь в отчёте «Ошибки» вы увидите только те ошибки, которые есть в этой категории. И наоборот → выберите пункт «Высокая критичность» на вкладке «Ошибки» (таким образом будут отфильтрованы все страницы с высокой критичностью), примените как сегмент и перейдите в отчёте «Структура сайта» - вы увидите все категории сайта, где присутствуют критические ошибки. 3. Применение сегментов влияет на все отчёты в программе, включая «Ошибки», «Сводку», «Структуру сайта», «Дашборд» и т.д. 4. Можно как воспользоваться преднастроенными сегментами, так и сохранять собственные. |

| Уникальный расчёт внутреннего PageRank | В Netpeak Spider мы реализовали уникальный расчёт внутренного PageRank. Этот инструмент поможет вам узнать настоящие инсайты о проекте: 1. Как именно распределяется ссылочный вес по сайту и где он концентрируется. 2. Какие неважные для поискового продвижения страницы получают избыточный вес. 3. Какие страницы являются «висячими узлами» и просто «сжигают» входящий ссылочный вес. К тому же, мы максимально доступно изложили особенности этого алгоритма в статье на нашем блоге: https://goo.gl/91cmYs |

| Комплексный анализ структуры сайта | 1. В панели «Отчёты» на вкладке «Структура сайта» отображается информация по всей структуре сайта, а не только топ-20 страниц, как во фроге. 2. Можно выгрузить полную структуру сайта с помощью функции расширенного копирования. 3. На этой вкладке можно нажать на любой пункт и таким образом отфильтровать все страницы данной категории. 4. Очень удобно использовать в связке с функцией сегментации. |

| Специальные статус-коды | 1. Доступен быстрый просмотр уникальных статус-кодов: например, 200 OK & Disallowed, что означает, что страница отдаёт нормальный ответ сервера, но страница закрыта от индексации в robots.txt. Таким образом, в одной колонке «Код ответа сервера (или Status Code)» вы увидите все инструкции, заданные для страницы. 2. Определение этих параметров заложено в ядре программы по умолчанию, то есть в настройках или параметрах вы можете выключить определение соответствующих инструкций по индексации, однако в этой колонке данные всё равно будут показываться и анализироваться на вкладе «Сводка» на панели «Отчёты». |

| Кастомная фильтрация результатов | 1. В основной таблице есть отдельная вкладка с отфильтрованными данными. Она отображается при выборе ошибки, определённого параметра в сводке и вообще любого раздела данных из боковой панели → таким образом можно работать с отфильтрованными результатами, не меняя таблицу со всеми результатами. 2. Также можно задать более сложные правила фильтрации самостоятельно: 3. Можно использовать преднастроенные фильтры, доступ к которым есть из разных мест программы («Дашборд» или боковая панель «Отчёты»). |

| Инструмент валидации XML Sitemap | 1. Валидатор найдёт более 30 ошибок файлов Sitemap и файлов индекса Sitemap. 2. Инструмент автоматически определит файлы индекса Sitemap (это не нужно самостоятельно указывать) и распакует gz-архивы. |

| Адаптивный дашборд | Дашборд отображается в двух разных состояниях в зависимости от этапа сканирования: 1. Во время сканирования здесь отображается краткая сводка с текущими настройками. А значит, здесь можно заметить неверные настройки, остановить сканирование и внести изменения. 2. После сканирования/на паузе на дашборде отображаются графики и диаграммы с полезными инсайтами о просканированных страницах. Они интерактивны → при нажатии на любой элемент соответственно отфильтруются результаты. Можно полностью экспортировать скриншот дашборда в.png и использовать в работе. |

| Быстрый экспорт любых данных | Экспорт данных в Netpeak Spider ограничен только вашим воображением 1. Можно настроить параметры экспортируемых файлов, как нравится: задать собственные имена экспортных файлов (с датой, названием проекта и название самого отчёта), включать/выключать подсказки по параметрам в XLS-отчётах, а также цветовую подсветку ячеек/строк в зависимости от критичности ошибки. 2. Выгрузка данных происходит именно так, как они отображаются в таблице с результатами (с учётом сортировки, группировки, порядка и ширины колонок, подсветки URL цветом, подсказок, если это XLSX). 3. В один клик экспортируется текущая таблица, а также все ошибки, все отчёты по ошибкам, все данные парсинга. 4. Можно за 1 клик экспортировать специальные отчёты с дополнительной информацией. Например, мы определяем определяем сущность «битая страница» (в которую входит очень много правил, а не только ссылки на 4xx-5xx страницы), потому все ссылки на битые страницы мы определяем и делаем на их основе специальный преднастроенный отчёт, который можно быстро экспортировать. 5. Из текущей таблицы результатов можно в 1 клик выгрузить в txt-файл только список URL. 6. После экспорта можно по нажатию на уведомление быстро открыть папку назначения с сохранённым отчётом. 7. Можно экспортировать даже данные всех вкладок бокового меню → просто выделить нужную область и воспользоваться функцией «Расширенное копирование». |

| Внутренняя база данных для работы с огромным количеством URL | Прямо внутри программы можно работать с внутренней базой данных, что особенно полезно для работы с миллионами URL: 1. Можно открыть любой параметр из базы данных (входящие/исходящие/внутренние/внешние ссылки, изображения, заголовки H1-H6, Canonical, Redirects, ошибки) для одного URL, выбранных URL, отфильтрованных URL или вообще всех результатов текущей таблицы. |

| Продвинутая таблица результатов | В нашем краулере вы сможете без проблем работать с большим количеством страниц (50 000, 100 000 и даже ещё больше): таблица Netpeak Spider лучшая на рынке и намного более оптимизирована для работы с большими объёмами данных. Вам доступны такие функции: 1. Сортировка данных. 2. Группировка данных. 3. Работа со столбцами: включение/выключение видимости, перенос, прикрепление, изменение размеров. 4. Подсветка ошибок в зависимости от степени критичности. 6. Расширенная работа с контекстным меню: помимо базовых функций → быстрый доступ к базе данных, быстрый переход к инструменту анализа исходного кода и HTTP-заголовков, возможность открытия выбранного URL в сервисах Google PageSpeed Insights и Mobile Friendly Test. 7. Возможность использования горячих клавиш, в том числе добавление URL в таблицу из буфера обмена по Ctrl+V. 8. Подсказки при введении URL в строку поиска (как в Google). 9. Добавление URL в таблицу с помощью Drag"n"Drop. 10. Подсказки по параметрам (в tooltip-формате), а также панель «Информация» с полезными данными о SEO-ошибках и параметрах. |

| Русскоязычный интерфейс программы | Вы сможете сами выбрать язык интерфейса нашего краулера: русский или английский. А также пообщаться с нашей командой поддержки на русском по любым интересующим вас вопросам |

| Автоматическое обновление программы | Установить апдейт программы максимально легко: просто запустите Netpeak Spider, и он автоматически обновится до самой последней версии. Не нужно дополнительно ничего скачивать с сайта и перезапускать: мы уже позаботились о вас с помощью нашей программы для запуска Netpeak Launcher. |

| Оперативная онлайн-поддержка всех пользователей | С любыми вопросами к нам можно обратиться в онлайн-чат на сайте: наши Customer Support менеджеры сразу придут к вам на помощь и помогут решить проблему быстро и качественно. Да и общаться с живым человеком всегда приятнее, чем просто переписываться по email К тому же, наша поддержка работает для всех наших пользователей, независимо от того, есть ли у них активная лицензия на продукт или нет. |

| Менее критичные фичи | |

| Полная кастомизация настроек сканирования | |

| Продвинутый парсинг данных | |

| Кастомные шаблоны настроек, параметров, фильтров и сегментов | |

| Расширенное копирование любой информации из вкладки «Отчёты» | |

| Более информативная сводка по сканированию для экспресс-аудитов | |

| Более продвинутый инструмент анализа исходного кода и HTTP-заголовков | |

| Отложенный анализ больших данных для оптимизации скорости сканирования | |

| Расширенная работа с контекстным меню | |

| Адаптивная панель «Информация» с пояснением к выбранному параметру или ошибке | |

| Совмещение нескольких режимов сканирования в один | |

| Отчёт по глубине сканирования | |

| Отчёт по редиректам, заблокированным в robots.txt | |

| Отчёт по цепочкам Canonical | |

| Отчёт по уникальным URL и анкорам | |

| Комплексный анализ всех заголовков h1-h6 | |

| Возможность использовать список прокси | |

| Импорт только URL из сохранённых проектов в Netpeak Spider и Checker | |

| Возможность очистки результатов сканирования | |

| Возможность удаления определённого типа URL из текущей таблицы | |

| Просмотр вида URL в исходном коде в инструменте анализа ссылок (база данных) | |

| Информация о длительности сканирования внизу программы | |

| Определение индексируемых URL | |

| Таблица пропущенных при сканировании ссылок | |

| В чем Netpeak Spider уступает Screaming Frog SEO Spider | |

| Название фичи | |

23 апреля 2018 года мне написала Александра, маркетолог из Netpeak , и предложила написать обзор их софта. Я сразу согласился: обзоры попадают в рассылку Netpeak Software, новые читатели это хорошо. А вот сам пост смог написать только сейчас, хех.

Давно пользуюсь Screaming Frog SEO Spider, полностью устраивает, поэтому пробовал с долей скептицизма. В таком софте я всегда использую только краулер, чтобы собрать урлы всех страниц на сайте, выгрузить их, и работать с ними руками или парсерами.

Переписывать описание программы с официального сайта не буду, расскажу про свой тест.

Навигация:

Тест на большом сайте

Неделю назад появился сайт, которому нужен аудит. Это большой интернет-магазин на Битриксе, который априори содержит множество ошибок и дублей страниц: «Лягушка» так старалась пройтись по всему сайту, что Макбук был на грани от вертикального взлёта на системе охлаждения. Сканирование завершил, ибо начались тормоза.

Вот и вызов для Netpeak Spider. Запускаю, вставляю сайт и жму Старт.

По умолчанию стоит 5 потоков, я заранее увеличил до 10.

За несколько часов краулер прошёлся по сайту на ~30000 страниц, без падений.

Быстрая работа

Понравилась оптимизация приложения. Хоть для MacOS доступна только версия 2.1 (команда разработчиков обещает в ближайшее время выкатить 3.0 на MacOS), она работает стабильней Screaming Frog SEO Spider. Да, его можно «подтюнить» и он сможет обрабатывать большие сайты, но как же лень .

Netpeak Spider ни разу не упал и всегда сохранял хорошую отзывчивость интерфейса, хотя в процессе парсинга я продолжал работать за ноутбуком. Тормозов в системе не было, сам ноутбук не грелся, кулеры работали очень тихо. Нагрузка на процессор была вполне ок.

Функционал

Не нашёл в Netpeak Spider каких-то особенных функций, которых нет в схожих программах. Зато работать тут проще, всё под рукой, а самое удобное - проверка 62 ошибок на каждой странице , по которой проходит «паук».

В данной версии их меньше, чем в , но самые важные на месте. Посмотреть их все можно на странице программы . Самое юзабельное:

- Анализ всех ссылок на на сайте , внешних и внутренних;

- По анализу внутренних ссылок можно высчитать внутренний PageRank ;

- Парсинг всей важной для seo-информации : заголовки, описания, подсчёт слов и символов в контенте;

- Проверка многих «стандартных» seo-ошибок : дубли title и заголовков h1-h6, дубли текста, пустые мета-теги;

- Проверка ответа сервера на всех страницах .

Настройки более тонкие, чем у Screaming Frog SEO Spider, например можно подробно настроить каким инструкциям по индексации следовать, а какие пропускать. Можно запретить или разрешить использовать cookies.

Параметры, которые проверяются на каждой странице, можно включать или отключать.

В Netpeak Spider есть фича со сбором необходимых данных на сайте. Полезно для сбора цены, ID товара и других параметров со страницы во время сканирования.

Ещё таким образом можно парсить информацию с сайтов конкурентов.

Проще всего находить нужный элемент через CSS-селектор. Если у нужного параметра его нет - задайте XPath, взять его можно через «Инструменты для разработчика» в Chrome.

Я сразу собирал цену товара, чтобы под рукой был актуальный список, для сравнения с конкурентами.

Итог

Если хочется парсить большие сайты и собирать 80% необходимой информации - Netpeak Spider отличный выбор.

Программа стоит денег, но есть бесплатный тестовый период с доступом к полному функционалу на 2 недели. Попробуйте .

К тому же у Netpeak Spider простой и понятный интерфейс, в сравнении с той же «Лягушкой».

Если не согласны с моим мнением - послушайте Диму.

Теперь жду релиза Netpeak Checker для MacOS и обновления краулера до версии 3.0.

Скачать бесплатно Netpeak Spider + торрент

Для установки не потребуется keygen или crack, а nulled-версии не существует. Вам необходимо скачать Netpeak Launcher и с его помощью установить .

Для читателей моего блога доступна специальная 10% скидка на покупку программ Netpeak Software. Чтобы её использовать, введите промокод Banochkin на этапе оплаты или кликните по кнопке ниже.

В Wordstat’е было много запросов с поиском torrent-файла для загрузки. Серьёзно, у вас ещё установлен торрент-клиент? В конце 2018 года? Хм, ну ок.

А вы чем пользуетесь в работе? Напишите свой любимый краулер в комментариях.